Common Crawl как альтернативный источник данных для восстановления сайтов

Когда речь заходит о восстановлении сайтов из архивов, почти все думают только о Wayback Machine. Это понятно: archive.org на слуху, у него удобный интерфейс, триллион сохранённых страниц. Но Wayback Machine не единственный крупный веб-архив в мире. Существует проект, который по объёму собранных данных сопоставим с Internet Archive, а в некоторых аспектах даже превосходит его. Этот проект называется Common Crawl, и о нём удивительно мало знают даже люди, профессионально работающие с веб-архивами.

В этой статье расскажем, что такое Common Crawl, чем он отличается от Wayback Machine, и в каких ситуациях он может стать спасением, когда archive.org не помог.

Common Crawl это некоммерческая организация, основанная в 2007 году. Её цель проста: регулярно сканировать весь доступный интернет и выкладывать результаты в открытый доступ. Звучит похоже на Internet Archive, но подход принципиально другой.

Wayback Machine сохраняет копии веб-страниц в том виде, в котором их видит пользователь. Вы вводите URL, выбираете дату и видите страницу как она выглядела в тот момент. Это удобно для просмотра и восстановления.

Common Crawl работает иначе. Каждый месяц (иногда чуть реже) их краулеры обходят миллиарды страниц и сохраняют результаты в виде огромных архивных файлов формата WARC. Эти файлы складываются на серверы Amazon S3 и доступны любому желающему бесплатно. На момент написания статьи архив содержит данные с 2008 года и занимает несколько петабайт.

Ключевое отличие: Common Crawl не предоставляет интерфейс для просмотра отдельных страниц по URL. У них нет аналога «машины времени», куда можно ввести адрес и посмотреть, как выглядел сайт в прошлом. Данные хранятся в сыром виде, и для работы с ними нужны технические навыки.

Именно из-за отсутствия удобного интерфейса Common Crawl остаётся малоизвестным среди вебмастеров. Зато его прекрасно знают в мире машинного обучения: датасеты Common Crawl использовались для обучения большинства крупных языковых моделей, включая GPT, LLaMA и многие другие.

Каждый краул (так называется один цикл сканирования) содержит от 2.5 до 3.5 миллиардов веб-страниц. Это колоссальный объём. Для сравнения: Wayback Machine за один месяц добавляет в среднем несколько сотен миллионов новых снэпшотов. То есть за один проход Common Crawl может захватить значительно больше страниц, чем Wayback Machine за тот же период.

Данные каждого краула разбиты на три типа файлов. WARC-файлы содержат полные HTTP-ответы: заголовки, HTML-код, изображения, скрипты. WAT-файлы содержат метаданные: извлечённые ссылки, заголовки, информацию о сервере. WET-файлы содержат только текстовое содержимое страниц, очищенное от разметки.

Для восстановления сайтов нас интересуют в первую очередь WARC-файлы, потому что в них есть полный HTML. Но работать с ними напрямую непросто: один краул может весить 50-80 терабайт, и файлы не отсортированы по доменам. Страницы одного сайта разбросаны по тысячам архивных файлов.

К счастью, у Common Crawl есть индекс. Он называется Columnar Index (раньше использовался cdx-index) и позволяет по URL или домену найти, в каком именно WARC-файле и по какому смещению хранится нужная страница. Без этого индекса работать с Common Crawl было бы практически невозможно.

В большинстве случаев для восстановления сайтов Wayback Machine остаётся лучшим выбором. У него глубокая история (с 1996 года), удобный доступ и API. Но есть ситуации, в которых Common Crawl оказывается единственным вариантом.

Первая ситуация: сайт заблокирован в Wayback Machine. Владелец сайта может отправить запрос на удаление в Internet Archive, и все архивные копии будут убраны. Также архив удаляет контент по требованию правообладателей или по решению суда. Если нужный вам сайт попал под такую блокировку, в Wayback Machine его больше нет. А вот в Common Crawl он вполне может сохраниться, потому что Common Crawl не обрабатывает индивидуальные запросы на удаление таким же образом.

Вторая ситуация: сайт был заблокирован через robots.txt. Wayback Machine уважает директивы robots.txt ретроактивно. Это значит, что если текущий robots.txt сайта запрещает доступ для краулеров, Wayback Machine скроет даже старые архивные копии, сделанные до появления этого запрета. Common Crawl тоже учитывает robots.txt при сканировании, но уже собранные данные не удаляет ретроактивно. Если страница была доступна в момент краула, она останется в архиве.

Третья ситуация: пробелы в архиве Wayback Machine. Не все сайты сканируются одинаково часто. Маленькие сайты с небольшим трафиком могут иметь всего несколько снэпшотов за весь период существования, и нужная вам версия может просто отсутствовать. Common Crawl сканирует интернет по другому алгоритму и с другими приоритетами, поэтому иногда находит страницы, которые Wayback Machine пропустил.

Четвёртая ситуация: массовое извлечение данных. Если вам нужно не восстановить один конкретный сайт, а проанализировать сотни или тысячи доменов (например, для исследования ссылочных профилей или анализа контента в определённой нише), Common Crawl оказывается удобнее. Его данные лежат на S3, к ним можно обращаться программно без ограничений по частоте запросов, которые есть у API Wayback Machine.

Для поиска конкретных URL или доменов в Common Crawl используется Index API. Он доступен по адресу index.commoncrawl.org. Запрос выглядит так:

https://index.commoncrawl.org/CC-MAIN-2025-51-index?url=archivarix.com/*&output=json

Здесь CC-MAIN-2025-51 это идентификатор конкретного краула (год и номер недели), а archivarix.com/* означает поиск всех страниц домена. В ответ вы получите JSON с информацией о найденных страницах: URL, HTTP-код, MIME-тип, а также координаты в WARC-файле (имя файла, смещение и длина).

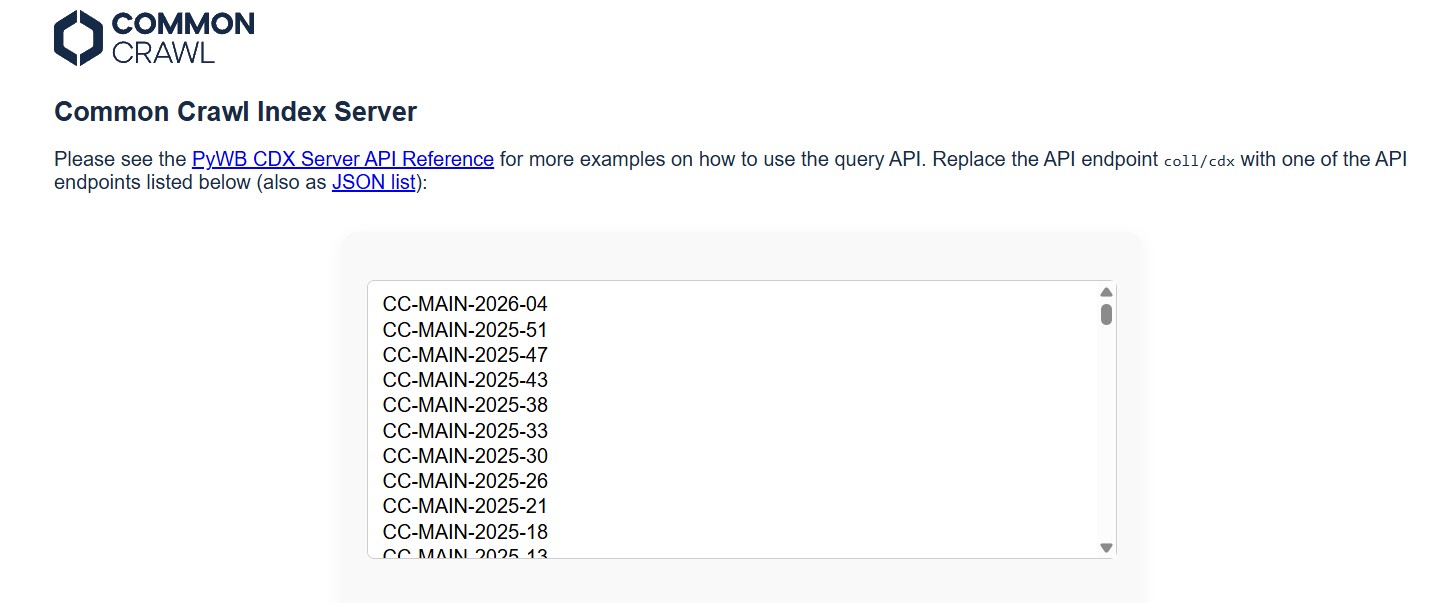

Чтобы узнать, какие краулы доступны, можно обратиться к:

https://index.commoncrawl.org/collinfo.json

Этот endpoint вернёт список всех проиндексированных краулов с датами.

Проблема в том, что искать нужно по каждому краулу отдельно. Если сайт вас интересует за всю историю, придётся перебрать все доступные краулы. Это десятки запросов, но процесс легко автоматизируется скриптом.

Получив координаты нужной страницы в WARC-файле, вы можете скачать только нужный фрагмент, не загружая весь файл (он может весить гигабайт). Для этого используется HTTP Range-запрос к S3:

https://data.commoncrawl.org/crawl-data/CC-MAIN-2025-51/segments/.../warc/CC-MAIN-....warc.gz

С заголовком Range: bytes=offset-end, где offset и end берутся из ответа индекса.

Ограничения Common Crawl

При всех достоинствах, у Common Crawl есть существенные ограничения, которые нужно учитывать.

Историческая глубина ограничена. Самые ранние данные датируются 2008 годом, но полноценные краулы с хорошим покрытием начинаются примерно с 2013-2014. Для сравнения: Wayback Machine хранит страницы с 1996 года. Если вам нужен сайт в том виде, как он выглядел в начале двухтысячных, Common Crawl не поможет.

Частота сканирования нерегулярна. Краулы проводятся примерно раз в месяц, но не каждый сайт попадает в каждый краул. Конкретная страница может быть в одном краулe и отсутствовать в следующих трёх. Непрерывной истории изменений, как в Wayback Machine, здесь нет.

Нет изображений и статических ресурсов в том смысле, в котором их сохраняет Wayback Machine. Common Crawl сохраняет HTTP-ответы, и если изображение отдавалось отдельным запросом (что чаще всего так и есть), оно может не попасть в архив. HTML-код страницы будет, но без картинок и CSS сайт будет выглядеть голым каркасом. Для полноценного восстановления визуального облика сайта этого может быть недостаточно.

Формат данных неудобен для ручной работы. WARC-файлы нужно парсить специальными библиотеками (warcio для Python, или утилита CDX Toolkit). Без навыков программирования работать с Common Crawl затруднительно.

Размер данных может быть проблемой. Даже если вам нужен только один домен, поиск по индексу и скачивание фрагментов WARC-файлов требует времени и стабильного интернет-соединения. Для крупных сайтов с десятками тысяч страниц процесс может занять несколько часов.

Работать с Common Crawl напрямую через HTTP-запросы можно, но утомительно. Существуют инструменты, которые упрощают процесс.

comcrawl. Простая Python-библиотека для поиска и скачивания страниц из Common Crawl. Несколько строк кода позволяют найти все архивные копии конкретного URL или домена и скачать их HTML.

cdx_toolkit. Более мощный инструмент от разработчика Greg Lindahl, который умеет работать одновременно с индексами Common Crawl и Wayback Machine CDX API. Удобен, когда нужно сравнить, что есть в обоих архивах.

cc-index-table. Если вам нужен масштабный анализ, Common Crawl публикует свой индекс в формате Apache Parquet, который можно обрабатывать через Amazon Athena или любой другой инструмент для работы с большими данными. Это позволяет делать запросы вроде «найди все страницы с домена *.gov.uk за 2024 год» за считанные секунды.

warcio. Низкоуровневая Python-библиотека для чтения и записи WARC-файлов. Пригодится, если вы хотите самостоятельно парсить скачанные архивы.

Использование материалов статьи разрешается только при условии размещения ссылки на источник: https://archivarix.com/ru/blog/commoncrawl/

Когда речь заходит о восстановлении сайтов из архивов, почти все думают только о Wayback Machine. Это понятно: archive.org на слуху, у него удобный интерфейс, триллион сохранённых страниц. Но Wayback …

Мы выпустили браузерное расширение Archivarix Cache Viewer. Оно доступно сразу для двух браузеров: Chrome и Firefox. Расширение бесплатное и без какой-либо рекламы.

Суть простая: быстрый доступ к кеш…

Когда вы восстанавливаете сайт из Web Archive, вы ожидаете получить оригинальный контент, который когда-то был написан живыми людьми. Но если архивы сайта были сделаны после 2023 года, есть реальный ш…

В октябре 2025 года Wayback Machine достиг отметки в один триллион сохранённых веб-страниц. Более 100 000 терабайт данных. Это огромное достижение для некоммерческой организации, которая работает с 19…

Мы рады представить версию 2.0 нашего WordPress плагина для импорта внешних изображений. Это не просто обновление, плагин полностью переписан с нуля с учётом современных требований и отзывов пользоват…

Дорогие друзья!

Black Friday и Cyber Monday - лучшее время для экономии на будущих восстановлении сайтов.

Если вы планируете восстанавливать сайты, пополнить баланс заранее или просто хотите получит…

Дорогие друзья!

Сегодня мы празднуем 8-летие сервиса Archivarix, и это повод сказать вам огромное спасибо!

Мы искренне рады, что вы выбрали наш сервис для восстановления сайтов из веб-архива. Многие…

Сегодня у нас особенный день — Archivarix празднует своё 7-летие! И мы хотим поблагодарить именно тебя за твоё доверие, идеи и обратную связь, которые помогли нам стать лучшими в деле восстановления с…

Дорогие пользователи Archivarix, Поздравляем вас с наступающими праздниками и благодарим за то, что вы выбрали наш сервис для архивации и восстановления веб-сайтов!…

Наступил момент, когда мы гордимся не только своими достижениями, но и вашим участием в этом пути. В этом году Archivarix празднует своё 6-летие, и в первую очередь мы хотели бы выразить огромную благ…